来源:arXiv

作者:Gaël Gendron、Jože M. Rožanec、Michael Witbrock、Gillian Dobbie

单位:Jožef Stefan研究所、奥克兰大学等

发表时间:2024年10月

一、论文介绍

背景:传统因果推理方法依赖结构化数据与显式变量,但在新闻文本等非结构化场景中面临变量未知、反事实数据缺失、潜在混杂因素复杂等挑战。尽管LLMs在因果推断中展现潜力,但其能力存在局限性(如依赖训练数据中的预存因果知识、逻辑推理错误)。

核心:基于上述背景,论文提出了一个反事实因果推理框架,基于LLM打造“多阶段反事实推理引擎”,通过三阶段流程(因果图提取→多源图融合→反事实干预)实现自然语言的因果推理。

二、反事实因果推理框架

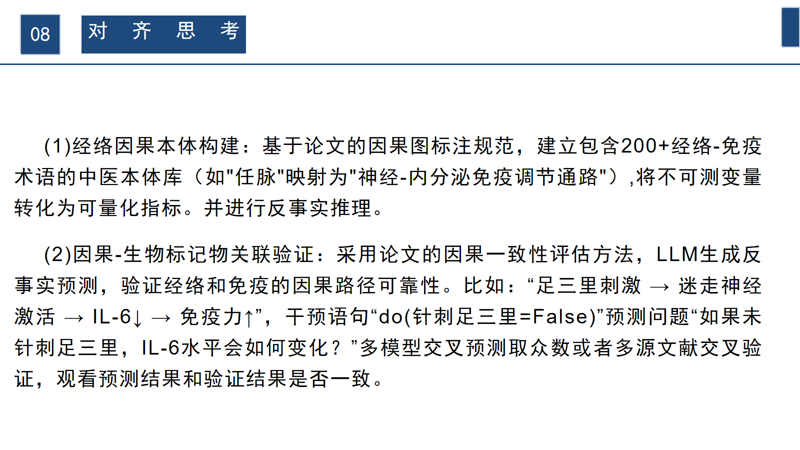

展示端到端流程的四个阶段:因果图提取(LLM从文本中识别变量与关系);图合并(多文本图的融合策略);反事实查询(对干预变量进行“what if”推理);因果图评估(LLM对生成图的自评分与置信度)。

三、因果推理步骤案例

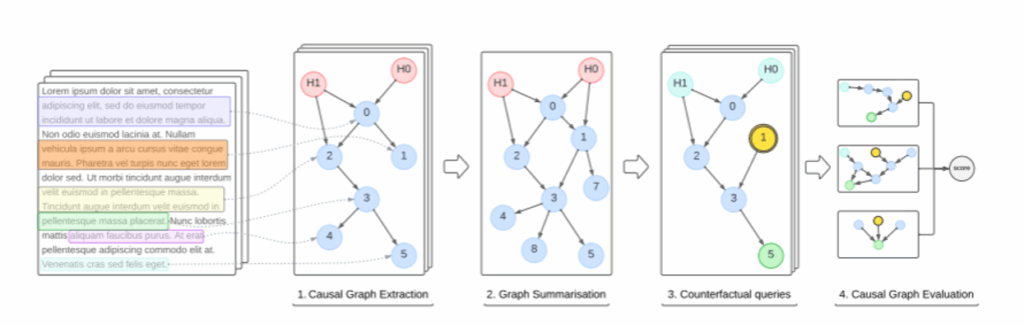

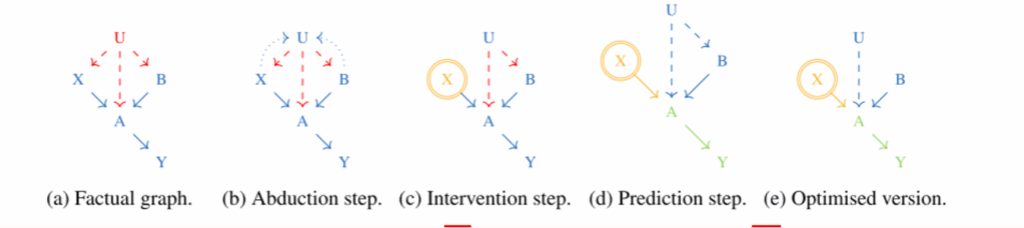

示例说明:事实图、推理步骤、干预步骤、预测步骤、优化版本

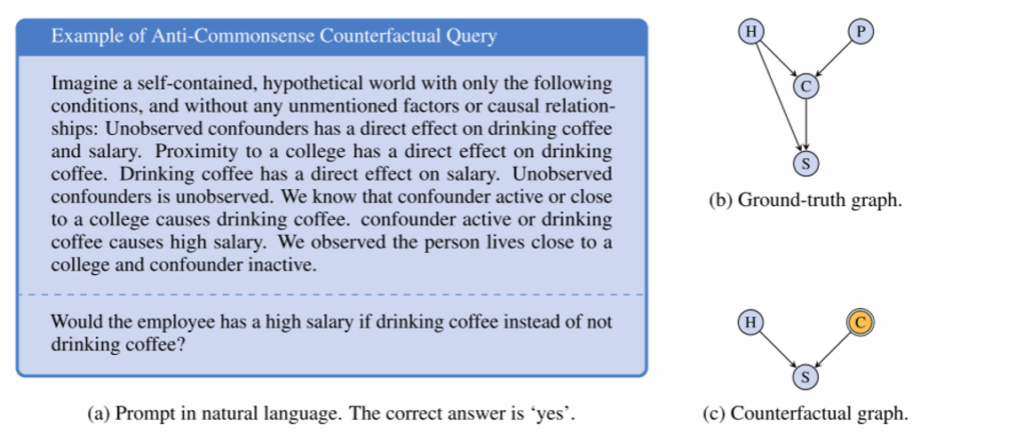

四、Cladder数据集的反事实查询示例

(左)提供给模型的自然语言的上下文和问题描述。(右)对应的基真和反事实因果图,(H)是一个隐藏的混杂因素,与现实世界的情况不同,它的值是在数据集中给出的,因此用蓝色显示,(C)喝咖啡,(S)高工资或低工资。

五、实验内容

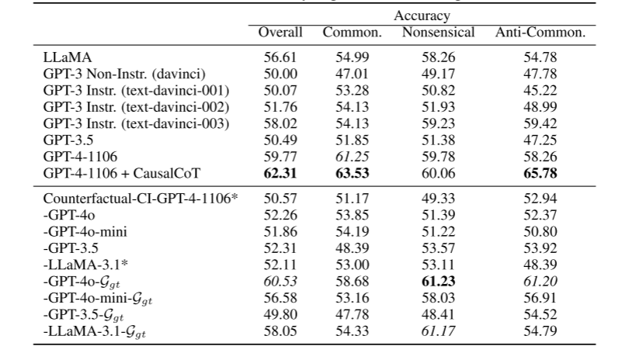

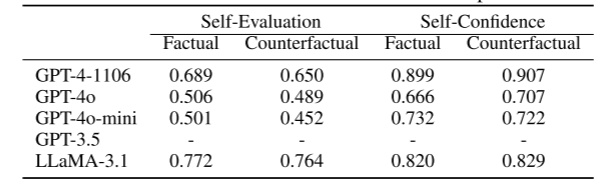

实验一:评估大语言模型在反事实推理任务中的预测准确率差异。

实验二:验证模型生成的因果图与真实因果结构的空间匹配度,显示了由模型构建的因果图与真值因果图之间的图形编辑距离(GED)。

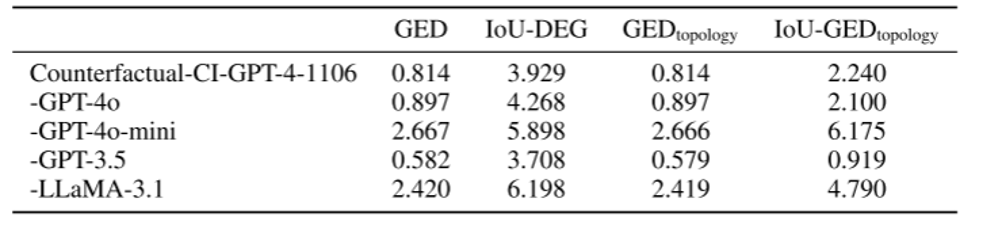

实验一:评估大语言模型生成反事实因果推理链的完整性与指令遵循能力。

实验二:量化模型对反事实推理错误的心理归因机制

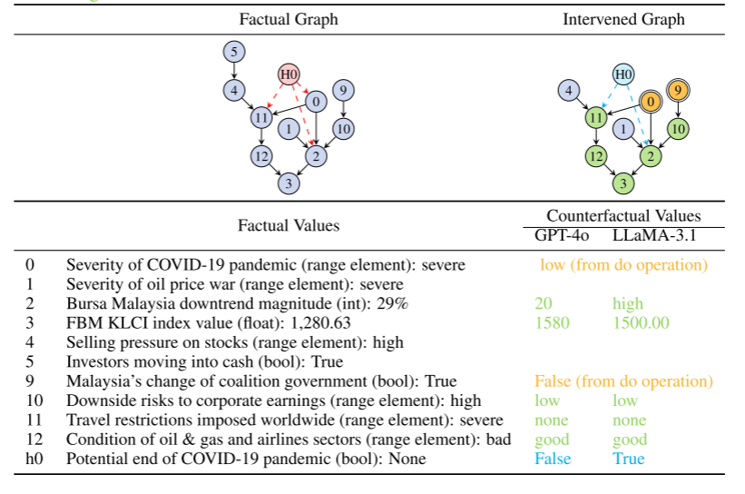

Counterfactual-CI模型在现实经济系统中执行多变量因果干预的反事实推理能力,量化模型对复杂系统动态的预测误差。第一行显示了在干预(黄色)do(0 =“低”)和do(9 =“假”)下提取的事实图和反事实图。外源性因素为红色。外展后,会为其指定一个值(以蓝色表示)。在预测步骤中推断的变量以绿色显示。最下面的几行显示的是事实世界和反事实世界的价值。

六、论文总结

七、论文启发