论文来源:CVPR2024

作者单位:苏黎世联邦理工学院、图宾根大学

作者:徐浩飞,彭松友

一、论文主要工作

3DGS 与单视图/多视图深度估计的集成提供了一种引人注目的解决方案,可以克服每种技术的各个限制,同时增强它们的优势。作者提出了 DepthSplat 来连接高斯飞溅和深度估计,并研究它们的相互作用。更具体地说,作者首先通过利用预先训练的单眼深度特征提供了一个强大的多视图深度模型,从而实现了高质量的前馈 3D 高斯飞溅重建。作者还表明,高斯飞溅可以作为从大规模未标记数据集中学习强大深度模型的无监督预训练目标。 作者通过广泛的消融和跨任务转移实验验证了高斯飞溅和深度估计之间的协同作用。

二、论文贡献

1.作者首先通过集成预先训练的单眼深度特征来贡献一个健壮的多视角深度模型到多视图特征匹配分支,它不仅可以保持多视图深度模型的一致性,而且在难以匹配的情况下。

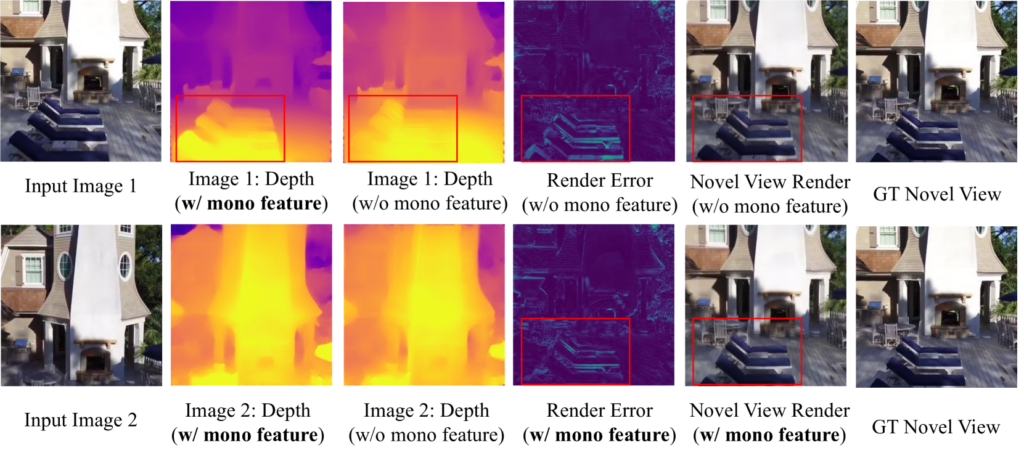

2.由于我们改进的多视图深度模型,使用高斯飞溅的新视图合成的质量也得到了显著提高。

3.此外,作者的 Gaussian splatting 模块是完全可微分的,只需要光度监督来优化所有模型组件。 这提供了一种新的无监督方法,可以在大规模未标记数据集上预训练深度预测模型,而无需真值几何信息。 预先训练的深度模型可以针对特定的深度任务进一步微调,并取得比从头开始训练更好的结果。

三、方法

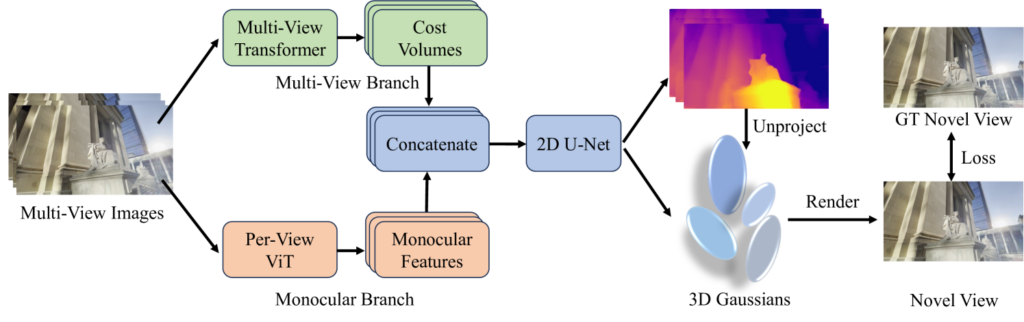

1.多视图特征匹配

在这个分支中,作者使用多视图 Transformer 架构提取多视图特征,然后构建与每个输入视图对应的多个成本量。

对于多视图特征提取,作者使用轻量级权重共享的ResNet老获取架构中每个图像的缩减采样特征。对于特征匹配,作者使用平面扫描立体方法对不同视图中的特征匹配信息进行编码。

2.单眼深度特征提取

基于多视图特征匹配的深度估计方法和高斯飞溅在遮挡、无纹理区域和反射表面受到限制,作者利用了最近Depth Anything的预训练单眼深度主干模型

3.特征融合和深度回归

为了实现稳健和多视图一致的深度预测,作者结合了弹幕特征和成本量,通过通道维度中的简单链接,随后的2DUNet用于从串联的单目特征和成本体积中回归深度。此外,作者还应用了分层匹配架构,其中额外的优化步骤采用更高的特征分辨率以进一步提高性能。

4.高斯参数预测

对于3D高斯展开任务,作者直接将每张像素深度图投影到3D,并将相机参数作为高斯中心,作者同时附加了一个额外的轻量级网络来预测其他高斯参数,借此,就可以用高斯飞溅操作来渲染新的视图图像。

四、实验

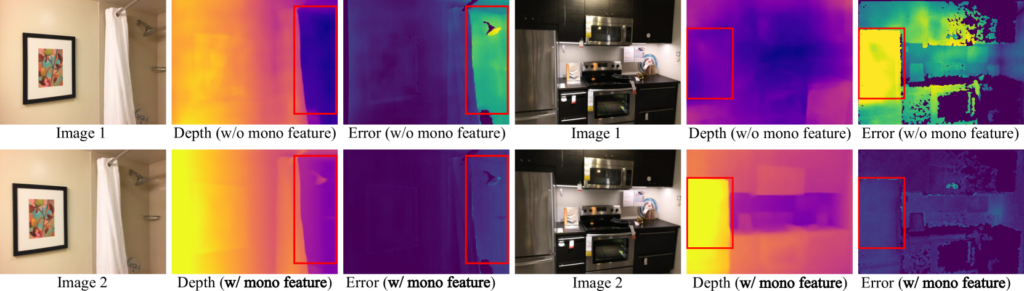

1.单眼特征对ScanNet深度的影响。单眼特征功能极大地改善了育有挑战性的情况,例如无纹理区域和反射表面

2.基准测试比较

五、总结

1.在本文中,作者介绍了 DepthSplat,这是一种连接高斯展开和深度的新方法,可在 ScanNet、RealEstate10K 和 DL3DV 数据集上获得最先进的结果,用于深度和视图合成任务。

2.作者的模型可以通过高斯飞溅渲染损失实现无监督的预训练深度。

3.作者还提供了一种利用大规模未标记的多视图图像数据集来训练更多多视图一致和稳健的深度模型的方法。