来源:arXiv

作者:Jiawei Zhang, Haopeng Zhang, Congying Xia, Li Sun

单位:北京邮电大学

一、论文主要工作及贡献

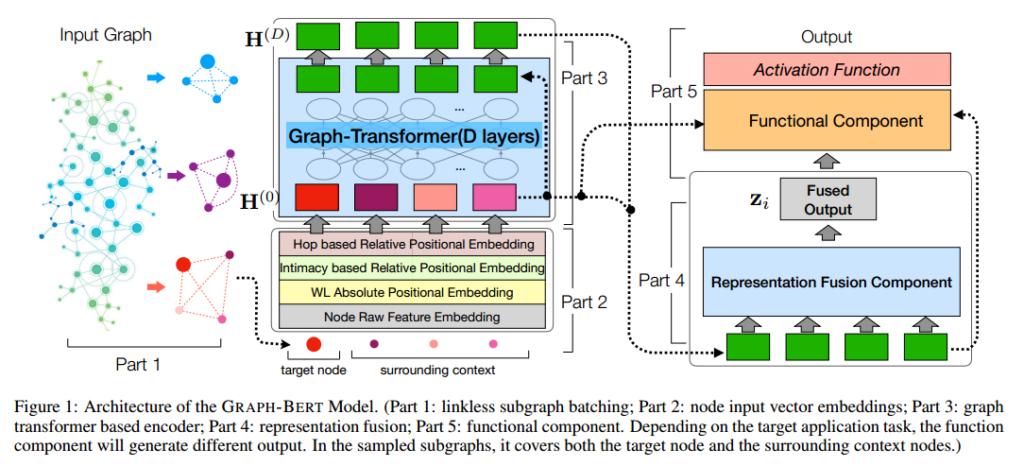

(1)这篇文章引入了一种新的GNN模型graph – bert,用于图数据表示学习。graph – bert不依赖于图链接进行表示学习,可以有效地解决假死问题。此外,graph – bert可以用采样的无链路子图(即带有上下文的目标节点)进行训练,这比为完整输入图构建的现有gnn更有效。

(2)作者基于图研究中两个常见的任务,即节点属性重构和图结构恢复,对graph – bert进行预训练。节点属性恢复确保学习到的节点表示能够捕获输入属性信息;而图结构恢复可以进一步确保使用无链接子图学习的GRAPH-BERT仍然可以保持图的局部和全局结构属性。

(3)根据特定的应用任务目标,graph – bert模型可以进一步微调,以使学习到的表示适应特定的应用需求,例如节点分类和图聚类。同时,预训练的graph – bert也可以转移应用到其他序列模型中,从而可以构建用于图学习的功能管道。

二、模型框架

2.1. Linkless Subgraph Batching

2.2. Node Input Vector Embeddings

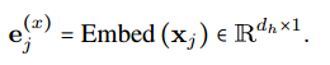

2.2.1.Raw Feature Vector Embedding

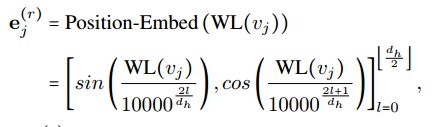

2.2.2.Weisfeiler-Lehman Absolute Role Embedding

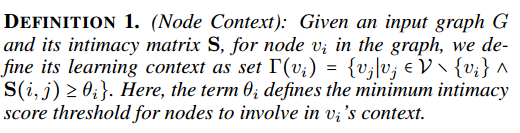

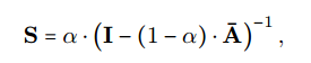

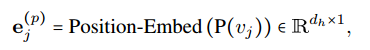

2.2.3. Intimacy based Relative Positional Embedding

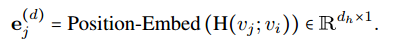

2.2.4. Hop based Relative Distance Embedding

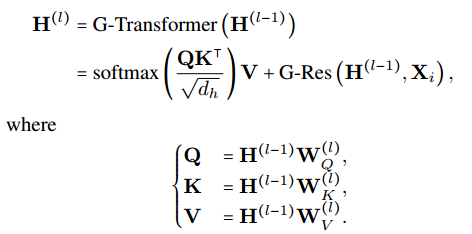

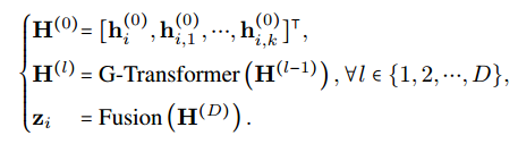

2.3. Graph Transformer based Encoder

2.4. GRAPH-BERT Learning

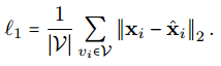

2.4.1.Node Raw Attribute Reconstruction

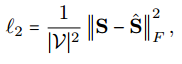

2.4.2.Graph Structure Recovery

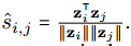

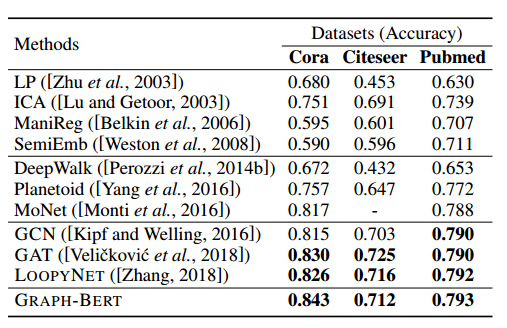

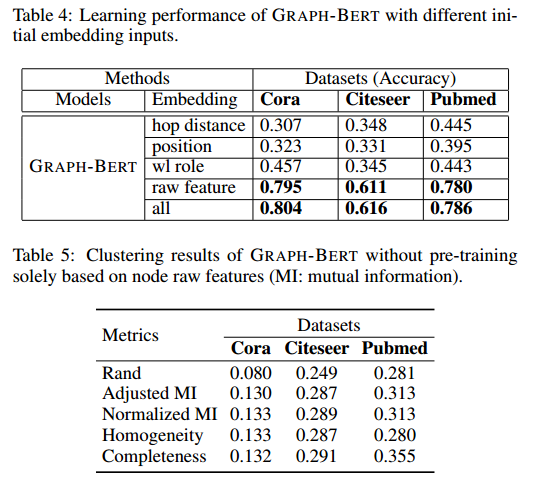

三、实验结果

四、总结与思考

1.这篇文章引入了新的graph – bert模型用于图表示学习。与现有的gnn不同,GRAPH-BERT在深度架构中工作得很好,并且不会遇到其他gnn的常见问题。

2.这篇文章基于从原始图数据中采样的一批无链接子图,graph- bert可以有效地学习目标节点的表示,这篇文章引入了扩展的Graph-Transformer。

3.无连接的子结构学习可以有效的解决大图所需要大量存储空间问题;可以从这个角度出发解决大图建模问题;

4.Graph-BERT可以有效的学习数据的表征,可以改变Transformer的结构进行图结构数据的学习。