作者:Matias Mattamala, Jonas Frey 等

单位:牛津大学、苏黎世联邦理工学院、马普智能系统研究所

来源:arXiv Artificial Intelligence

时间:2024.04

一、研究背景

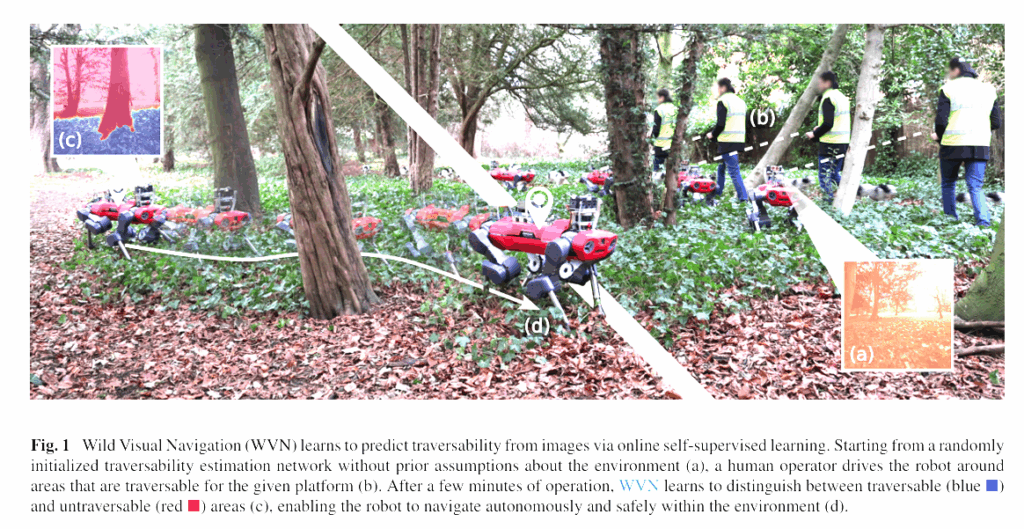

该研究聚焦于野外视觉导航(Wild Visual Navigation, WVN),即在自然环境(森林、草地、灌丛等)中,机器人仅依赖视觉感知实现自主行走。传统方法主要依靠几何特征(如地形高差、坡度)**评估可通行性(traversability),但在野外场景中,诸如高草、枝叶、灌木等柔性障碍常被误判为刚性物体,从而阻碍机器人前进。

以往基于深度学习的导航模型通常需要大量标注数据,并在训练后静态部署,缺乏在线自适应能力,难以应对不同地貌和照明条件的变化。

为解决这一问题,作者提出 Wild Visual Navigation (WVN) 系统:

- 利用预训练的自监督视觉模型(如 DINO-ViT、STEGO),提取高维视觉语义特征;

- 在机器人运行过程中,基于自身运动反馈生成监督信号,实现在线自监督学习与即时推理;

- 使机器人在数分钟的示范学习后,即能在全新自然环境中实现稳定自主导航。

二、核心内容

论文提出了一个在线自监督可通行性估计框架 WVN,其核心思想包括:

- 高维特征语义迁移:利用大规模自监督模型(DINO-ViT、STEGO)提取视觉特征,无需人工标注即可编码语义相似性;

- 在线自监督机制:机器人根据自身速度反馈计算可通行性得分(traversability score),作为训练标签;

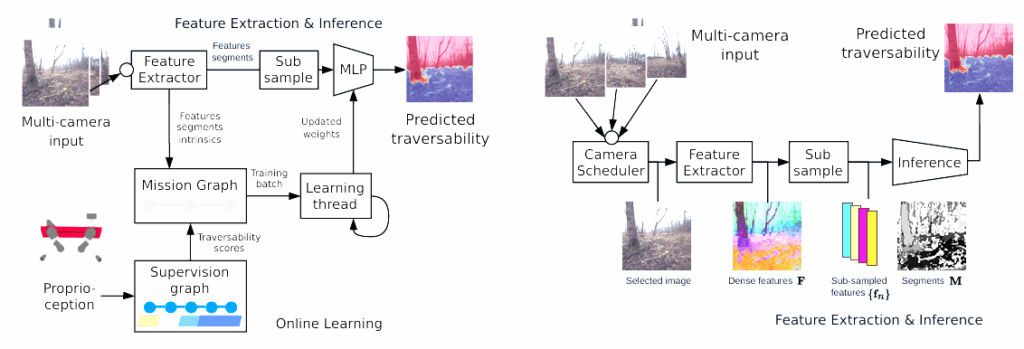

- 双线程架构:

- 一条线程执行特征提取与推理;

- 另一条线程执行监督生成与在线学习;

二者并行工作,实现实时更新与预测;

- 多相机感知与任务图机制:通过监督图(Supervision Graph)与任务图(Mission Graph)管理短期与全局经验,保证时空一致性;

- 异常检测与置信度调控:采用重建误差(autoencoder)度量特征置信度,从而提升未知区域的安全性与学习效率。

三、核心框架与系统模块

1. 系统概览

WVN 的输入为 RGB 图像、里程计与机器人自身状态(速度、加速度),输出为每个像素的可通行性概率图。系统由两大并行流程组成:

- 特征提取与推理模块:负责从图像中提取特征并生成通行性预测;

- 在线学习模块:从机器人运动反馈中生成监督信号并更新模型参数。

2. 特征提取与推理(Feature Extraction & Inference)

- 多相机调度:通过加权轮询算法动态选择输入图像;

- 特征提取:使用自监督预训练网络(DINO-ViT 提供 384 维特征,STEGO 提供 90 维特征与弱分割掩膜);

- 特征子采样:通过 SLIC、STEGO、随机采样三种策略将 224×224 像素降维为约 100 个特征嵌入;

- 推理方式:既支持分段预测(segment-wise)也支持像素级预测(pixel-wise),后者提供更精细的导航精度。

3. 在线学习(Online Learning)

- 可通行性得分生成:通过机器人指令速度与实际速度差计算“牵引误差”,经 Sigmoid 函数映射为连续可通行性值 τ∈[0,1];

- 监督图与任务图:

- 监督图(Supervision Graph):短时缓存机器人轨迹与通行性得分;

- 任务图(Mission Graph):记录长期特征、图像与监督数据,用于在线训练;

- 监督生成:通过视角重投影,将机器人行走轨迹重新映射到历史图像以生成训练标签。

4. 异常检测与置信学习

- 重建网络(fᵣₑcₒ):仅重建已通过区域特征,未通过区域将呈现高重建误差,形成异常检测机制;

- 置信度估计(Confidence Estimation):根据重建误差分布计算置信值 c∈[0,1];

- 加权损失函数:采用置信度加权的 MSE 损失,降低未标注区域的负面影响,实现安全学习。

四、实验与结果

1. 实验设置

平台:ANYmal C / D 四足机器人(配备 NVIDIA Jetson Orin AGX)。

环境:英国牛津大学公园、Wytham 森林、德国图宾根研究所等自然场景。

对比基线:

- 传统几何方法(基于地形高度与坡度);

- 学习型几何方法(基于地形映射系统);

- WVN(视觉自监督)。

2. 实验结果

- 快速适应性:仅需 <5 分钟人工示范,即可在全新环境中实现正确的通行性分割;

- 可视 vs 几何比较:在高草或柔性障碍场景中,WVN 能区分“可穿越的柔性障碍”与“不可穿越的刚体”,明显优于几何方法;

- 自主导航任务:在树林场景中,WVN 经过 2 分钟学习后即可实现 8/8 成功的自主点到点导航;

- 公里级连续导航:在公园路径中,机器人成功完成最长 1.4 km 的自主路径跟随,仅需轻微人工干预;

- 多相机部署:实现从室内到室外的自适应过渡,准确识别玻璃门、草地、道路等多类型地面。

3. 离线分析

- 像素级预测优于分段预测,可提供更细粒度的可通行性估计;

- STEGO 特征子采样策略在训练收敛速度与预测稳定性上表现最佳;

- 实验表明语义特征迁移极大地加速了在线学习的适应过程。

五、总结与展望

主要贡献

- 提出WVN 框架,实现了野外环境下基于视觉输入的在线自监督可通行性估计;

- 引入预训练自监督模型的语义特征迁移,显著减少标注依赖;

- 构建双线程学习架构与任务图机制,实现同时训练与推理;

- 实现快速现场学习(<5min)与真实环境自适应导航;

- 代码与模型开源,支持 ROS 集成与多相机扩展。

局限性

- 使用牵引误差作为通行性度量存在噪声与不确定性;

- 长期运行的漂移与动态环境变化仍影响性能;

- 对于极端复杂地形(如泥泞、雪地)的泛化能力仍需验证。

未来方向

- 引入多模态感知融合(如触觉、音频、红外);

- 改进自监督信号的鲁棒性与语义一致性;

- 构建长期在线学习机制,支持跨环境记忆迁移与持续适应。