作者:Ji Shihao, Song Zihui, Zhong Fucheng, Jia Jisen, Wu Zhaobo, Cao Zheyi, Xu Tianhao.

单位:Data Dream, AI.

来源:arXiv

时间:2025.1

一、论文介绍

核心问题:

LLM在复杂推理中存在逻辑不一致性;

现有方法(如CoT)缺乏自我反思机制;

学习优化模型(LRM)需额外训练,计算成本高。

目标:

提出无需训练的轻量级方法 Multiplex CoT,通过双重思维链提升推理质量。

二、主要内容

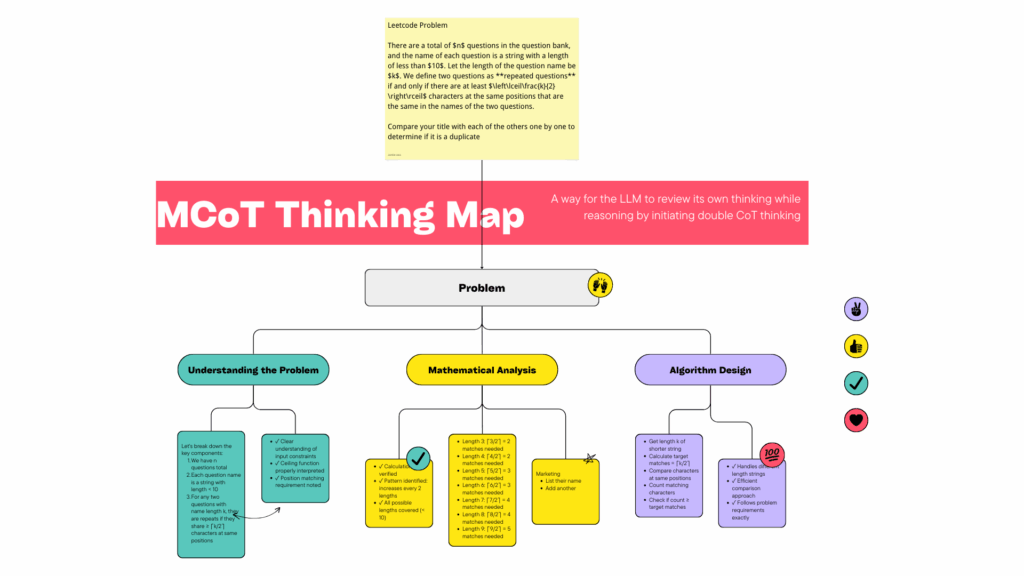

Multiplex CoT:一种双链思维方法

Multiplex CoT 将 CoT 推理的优势与自我反射机制相结合。该过程概述如下:

1. 初始 CoT 生成:该模型生成一个推理链,其中思维过程的每一步都被阐明并用于得出最终结论。

2. 审查和改进:在生成初始 CoT 后,模型随后启动第二轮推理,对第一个 CoT 进行批评。第二条思路评估初始推理的逻辑一致性,识别任何潜在的缺陷或不一致之处。

3. 最终输出:根据批评,模型完善其推理,产生更连贯、更准确的最终答案。

这个两阶段的过程模仿了类似人类的自我反思,其中第一阶段涉及产生想法,第二阶段侧重于评估和完善这些想法。该方法旨在与现有的 LLM 架构无缝协作,而无需对底层模型参数进行任何更改。

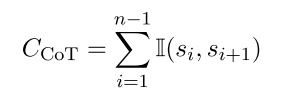

逻辑一致性和连贯性

Multiplex CoT 的主要优势在于它能够通过审查和完善初始输出来迭代改进推理过程。该文将逻辑一致性定义为连续推理步骤之间的有效逻辑连接数。如果 si 代表思维链中的第 i 步,I(si, si+1) 是一个指示函数,如果 si 和 si+1 之间存在逻辑连接,则返回 1,那么单个思维链的逻辑一致性 C 为:

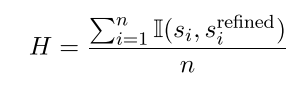

在应用 Multiplex CoT 时,进行第二轮推理,对初始推理进行批判和完善。该文将推理过程的连贯性定义为初始推理步骤和精细推理步骤之间的一致性程度。连贯性 H 可以量化为:

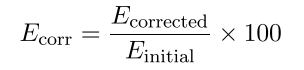

纠错率

Multiplex CoT 的主要好处之一是它能够在第二轮思维生成期间纠正初始推理链中的错误。该文将纠错率 Ecorr 定义为在第二轮推理中识别和纠正的错误比例。设 Einitial 表示初始思维链中的错误数,Ecorrected 表示在审阅期间更正的错误数。纠错率可以计算为:

三、实验评估

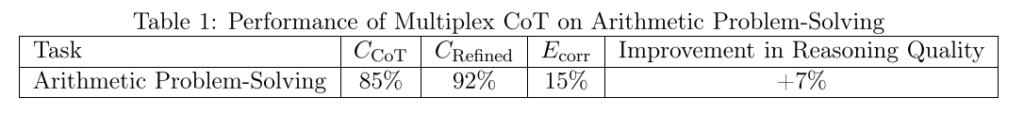

为了验证 Multiplex CoT 的影响,作者在各种任务中进行了一系列实验。对于每个任务,该文测量了应用 Multiplex CoT 前后的逻辑一致性和纠错率。以下是算术问题解决任务的结果摘要。在这个例子中,Multiplex CoT 方法将逻辑一致性提高了 7%,而纠错率为 15%,这表明该模型能够在自我反思阶段识别和纠正很大一部分错误。

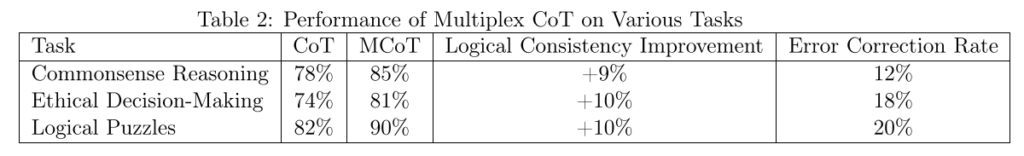

该文还评估了 Multiplex CoT 对算术以外的任务的影响,例如常识性推理、道德决策和逻辑谜题。表 2 总结了这些任务的性能。

如图所示,Multiplex CoT 提高了所有任务中推理的逻辑一致性,在道德决策和逻辑谜题中观察到显着的纠错率。这些结果突出了 Multiplex CoT 在需要多步推理和批判性分析的任务中的有效性。

四、论文总结

该文提供了 Multiplex CoT 的详细数学分析,量化了其对逻辑一致性、连贯性和纠错率的影响。研究结果表明,Multiplex CoT 通过提高推理质量和模型的自我纠正能力,显着增强了大型语言模型的推理过程。通过迭代改进,Multiplex CoT 优于传统的单阶段思维链推理,为需要逻辑严谨性和批判性反思的任务提供了更强大的方法。理论见解和实验结果的结合证实,Multiplex CoT 为提高 LLM 性能提供了一种可扩展且有效的方法,使其成为需要准确、连贯和一致推理的应用的宝贵工具。