来源:计算语言学协会第60届年会论文集, 2022

作者: Ningning Wang, Guobing Gan, Peng Zhang, Shuai Zhang, Junqiu Wei, Qun Liu, Xin Jiang

单位:天津大学智能与计算学院

一、论文主要工作及贡献

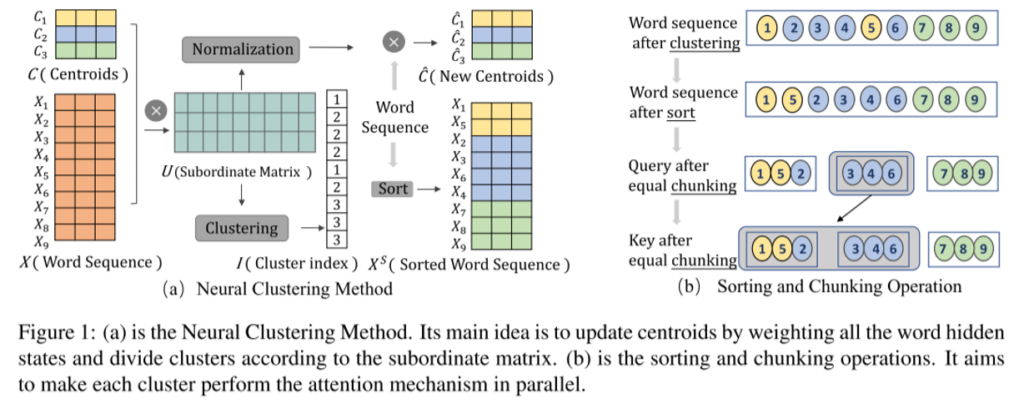

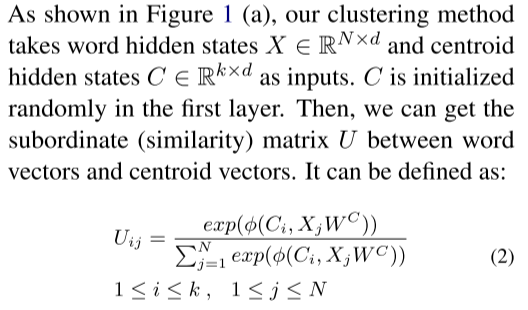

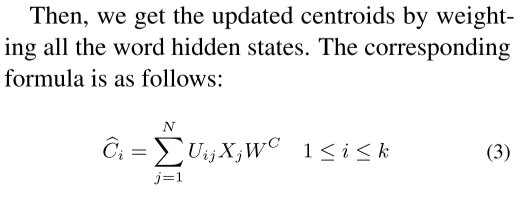

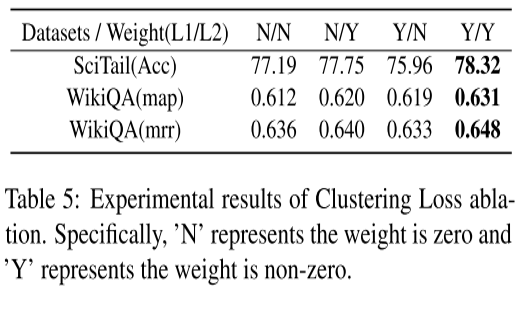

为了解决许多Transformer有效性下降的问题,尤其是基于模式的稀疏方法,这篇论文提出了神经聚类方法来学习注意力的稀疏模式。 它可以无缝集成到神经网络中以进行联合培训和优化。在论文中,群集中心(Centroid)通过所有单词隐藏状态的加权总和进行更新。 同时,群集成员根据质心和单词隐藏状态的下属矩阵进行划分。聚类损失的优化可以指导单词隐藏状态的表示,同时学习集群质心。 神经聚类方法和注意力训练的整合使文中的神经聚类注意力比以前的基于聚类的稀疏注意机制更好。

主要贡献:

1.提出了一种基于神经网络的通过的端到端模糊聚类方法,名为神经聚类方法,该方法可以动态地学习每个单词的权重,然后通过加权所有输入单词以及对特定任务的培训来更新质心。

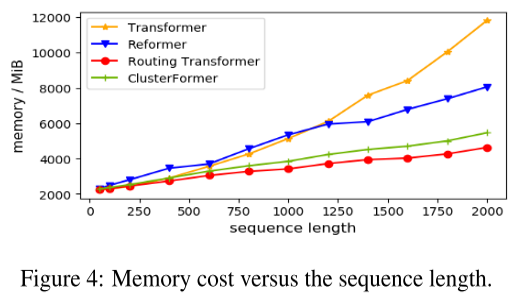

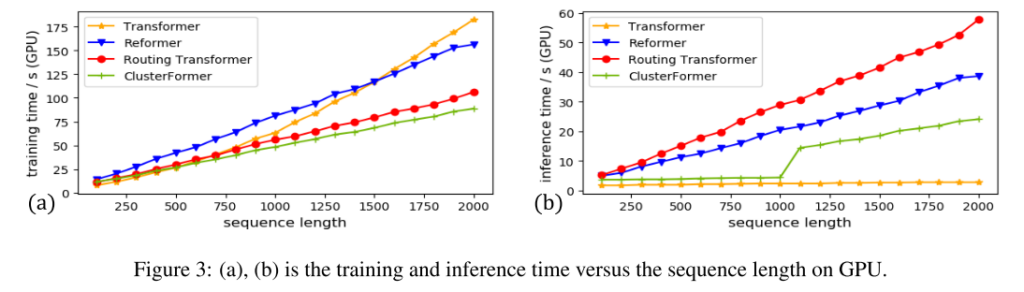

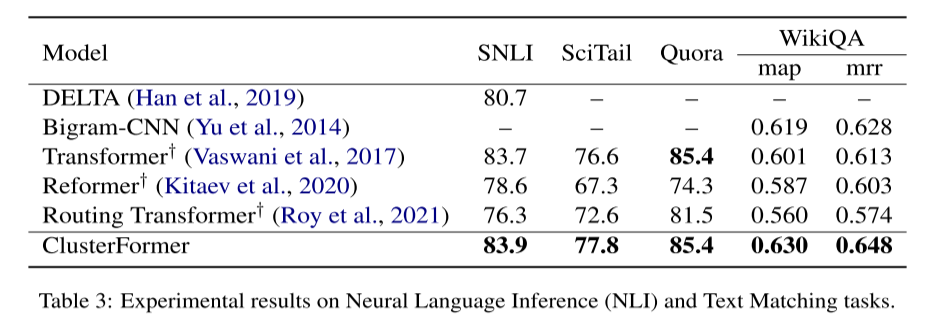

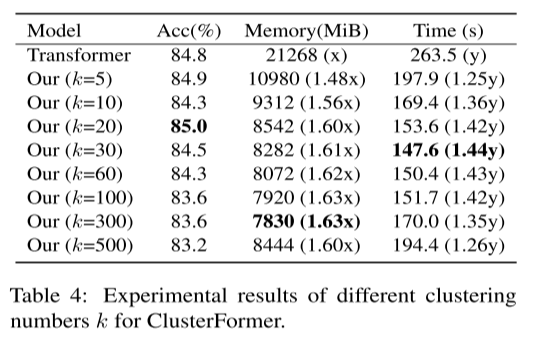

2. 根据提出的聚类方法设计神经聚类注意机制,以重构自注意力机制。实验结果表明,与典型的稀疏注意模型相比,这篇论文的方法具有突出的效率和更好的有效性。

二、模型框架

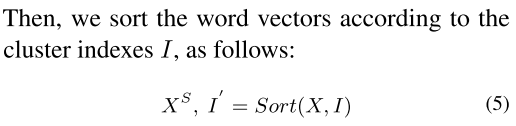

2.1. Neural Clustering Method

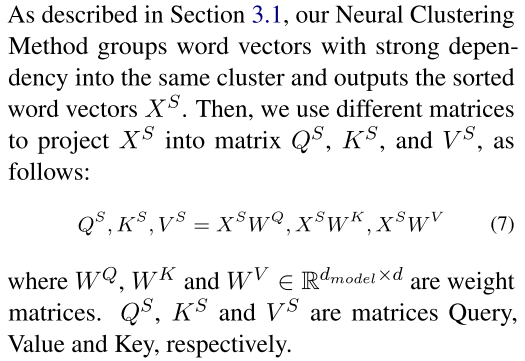

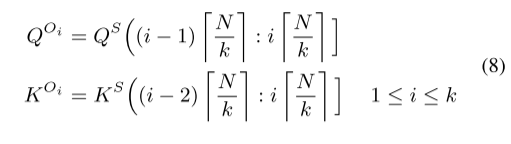

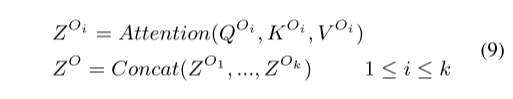

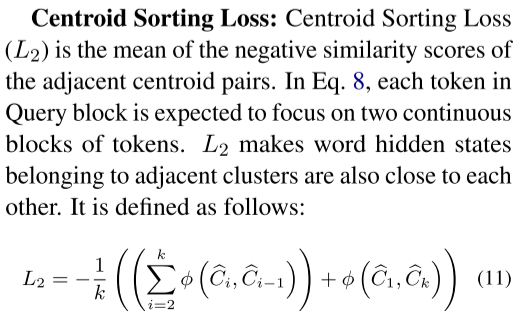

2.2. Neural Clustering Attention Mechanism

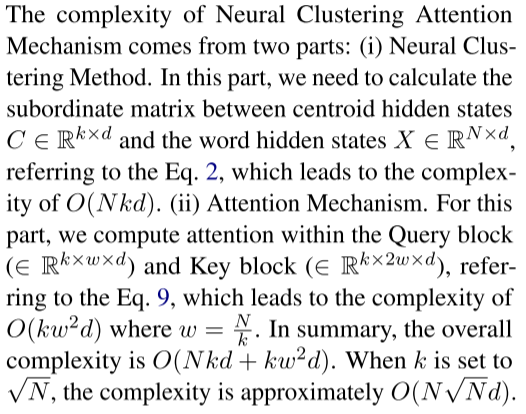

2.3. Analysis of Complexity

三、实验结果

四、总结与思考

(一)、论文的核心内容:

1.这篇文章提出了一种神经聚集注意机制,以解决稀疏注意方法中降低的有效性问题。 这个问题主要是由于引入与目标任务分开的稀疏模式引起的,或者不考虑单词之间的相似性。 而本文设计了一种神经聚类算法,以更好地捕获依赖关系的关键对。 将这种聚类算法和神经网络集成在一起,以共同训练和优化特定的任务,以进一步促进有效性和效率。

(二)、综合对齐思考:

1.这篇论文主要是通过神经聚类来降低Transformer模型的复杂度,文中的聚类本质上就是初始化聚类中心,在训练中进行优化,为下游任务做准备。

2.在聚类上与向量量化策略有异曲同工之处。