作者:Junjie Wang

来源:CVPR

时间:2024

一、研究目标

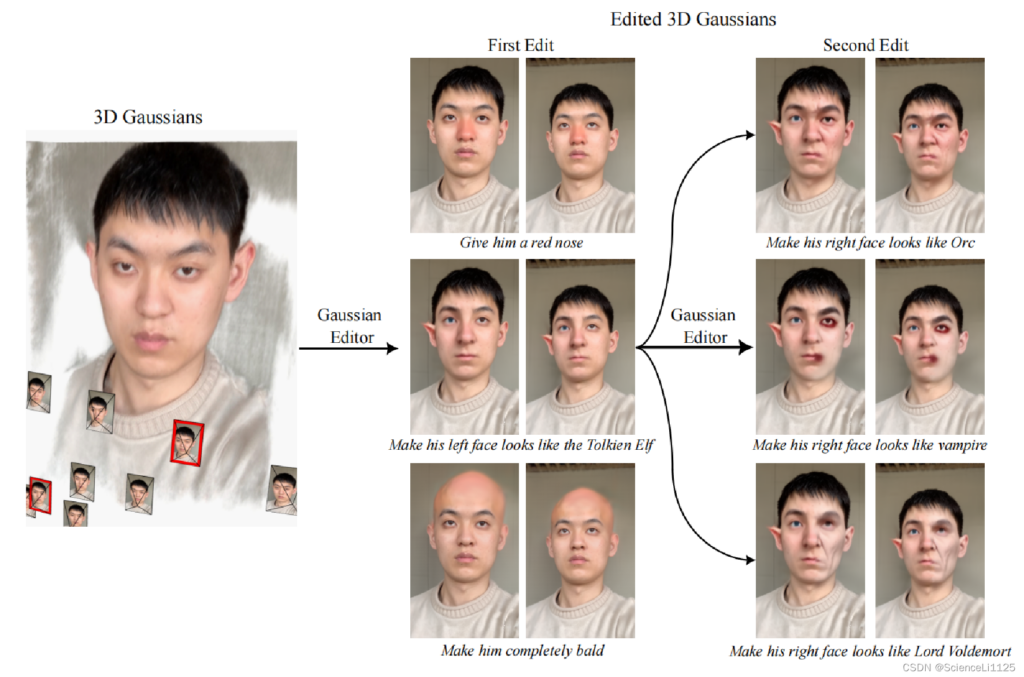

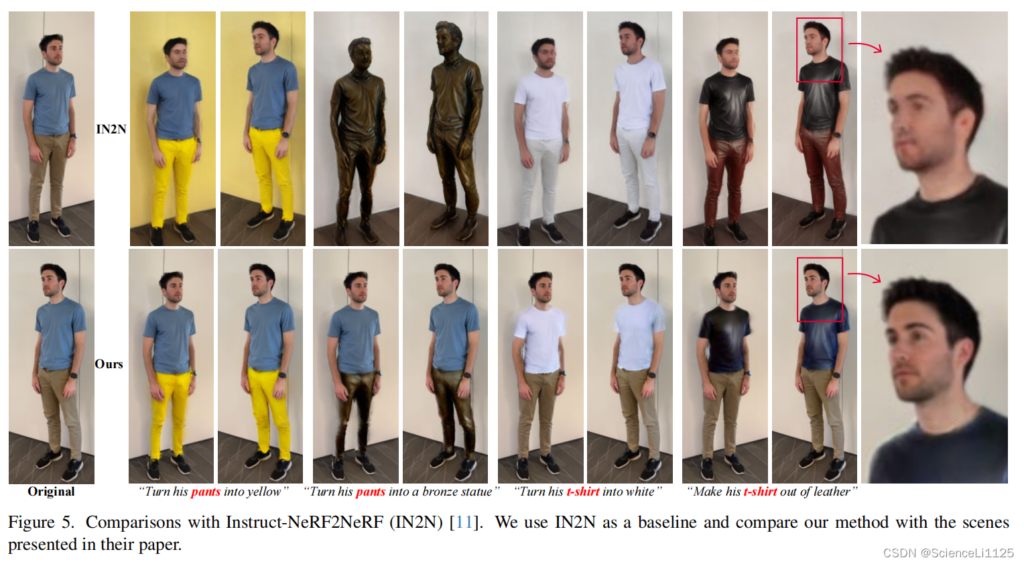

本文提出了一种基于3D高斯分布的场景编辑框架——GaussianEditor,旨在通过文本指令实现对3D场景的精细编辑。该方法利用了3D高斯分布在渲染过程中的自然特性,能够精确控制编辑区域和进行多轮编辑,显著提高了编辑的精度和效率。与现有的基于神经辐射场(NeRF)的方法相比,GaussianEditor不仅实现了更精细的编辑效果,而且训练速度更快。其工作流程包括从文本指令中提取感兴趣区域(RoI)、将RoI与3D高斯分布对齐以及在对齐后的高斯分布上执行编辑操作。此外,文中还介绍了如何通过增加用户交互来进一步提高编辑的准确性,并展示了GaussianEditor在不同场景下的实验结果,证明了其在复杂场景中也能实现高质量的编辑。最后,通过与Instruct-NeRF2NeRF方法的比较,验证了GaussianEditor在保持图像质量的同时具备更好的编辑能力。总体而言,GaussianEditor为3D场景编辑提供了一个新的高效、精准的解决方案。

二、研究思路及框架

由于 3D-GS 显示表达的优势,可以通过调整 Gaussians 参数来实现对三维场景的编辑。

1. 候选编辑区域的文本描述提取

2. 候选编辑区域的场景对齐

3. 候选编辑区域的场景编辑

三、研究结论及分析

本篇的 GaussianEditor 对 GS 场景的编辑主要适用于风格迁移,对于增加或删除元素的编辑任务,效果相当有限

四、总结与思考

课题价值:

文中介绍了如何通过增加用户交互来进一步提高编辑的准确性,并展示了GaussianEditor在不同场景下的实验结果,证明了其在复杂场景中也能实现高质量的编辑。

启发:

能够将3D编辑的思想转换为我们所需要的多视角的编辑,从而指导多视角下的精细编辑。