- 发表自:Google DeepMind

- 作者:Xuezhi Wang, Denny Zhou

- 发布平台:NeurIPS 2024

核心内容

- 这篇文章提出:只需要稍微改变解码方式,大模型就可以在不借助特别的训练以及提示词的情况下执行思维链的推理;这证明大模型的推理能力是固有的,不需要特别的外在干预来产生;

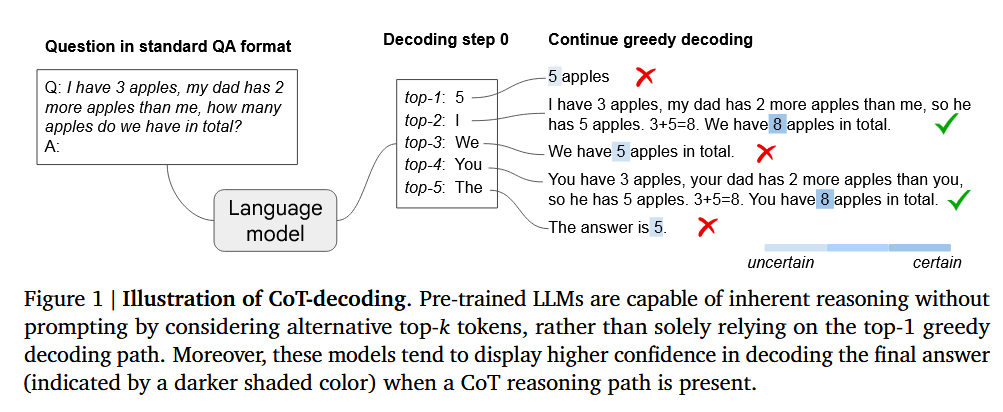

- 具体方法而言,在大语言模型生成第一个 token 的过程中,保留 top-k 个最好的 token;接着分别以这 k 个 token 为开端,生成全部回答;正确生成了思维链的答案对应的 token 置信度会远高于错误答案;

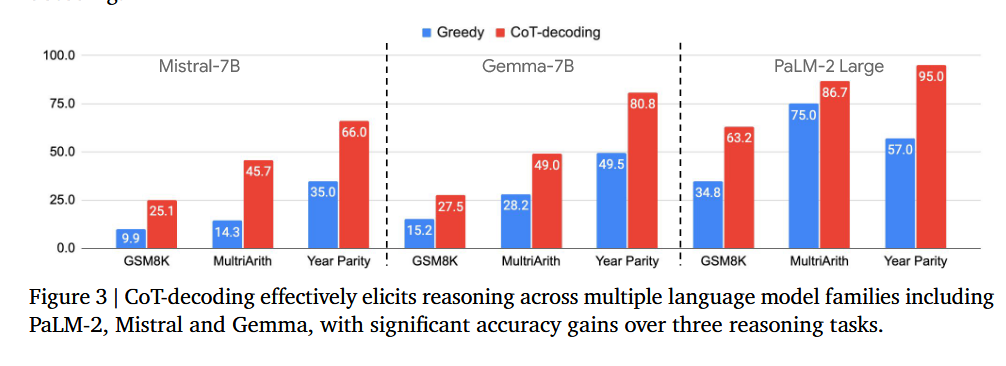

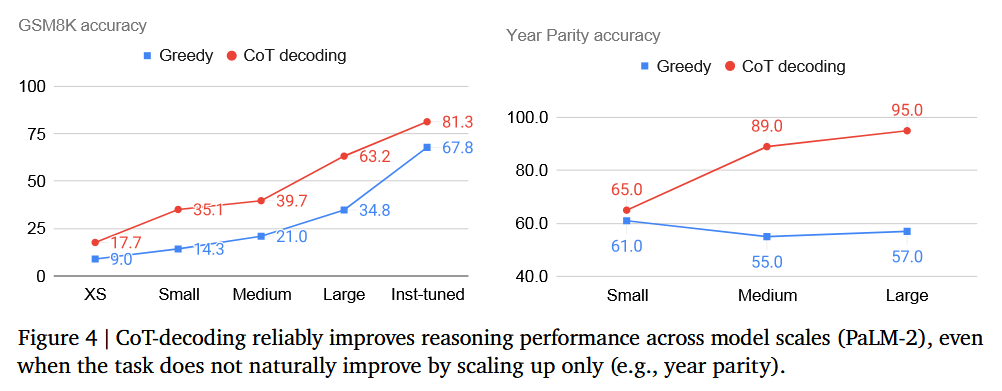

- 基于这个思路,这篇文章提出了思维链解码(Chain-of-Thought-Decoding,CoT-Decoding);通过用选择高置信度的回答替代原本的贪心策略,大模型在各个基准上面的表现都有显著提升。

背景

- 当前,大模型已经展现出来了很强的推理能力,在各种推理问题数据集上都取得了不错的效果;但是这些方法基本上可以归为两类:

- 提示词要发挥作用需要反复根据结果去修改提示词;微调模型则消耗大量计算资源。本文则发现其实只需要修改一下大模型生成 token 时的贪心策略,就可以展现出大模型固有的推理能力;为我们理解大模型提供了新的灵感。

方法论

生成多条问答路径

本文使用的方法思路十分简单,一张图就能概括:

- 将问题直接输入给大模型;

- 大模型以自回归的方式逐 token 生成答案;

- 取大模型生成第一个 token 时候的输出,保留 top-k 个 token 作为起点;

- 让大模型分别从这 k 个起点开始,按照传统的方式继续生成全部回答。

然后可以发现从一些不是最佳选择的 token 开始,大模型可以生成正确的思维链,无需特别的引导。

作者认为,造成这种现象的原因是模型主要是在不需要推理的简单问题上进行训练的,这使得模型天然倾向于一步得出答案。

置信度

另一个发现是,包含正确思维链的回答,其和答案相关那几个 token 平均置信度更高。这里的置信度指的是表示答案的那几个 token 产生的概率均值要高。以 $\Delta_{k,\text{answer}}$ 表示:

$$

\Delta_{k,\text{answer}}=\frac{1}{|\text{answer}|}\sum_{x_{t}\in \text{answer}}[P(x_{t}^{(1)}|x_{<t})-P(x_{t}^{(2)}|x_{<t})]

$$

- $k$:第 k 个回答;

- $\text{answer}$:正确答案所在的 token 集合;

- $t$:当前生成的是第 t 个 token;

- $x^{(1)},x^{(2)}$:第 t 步的 top-2 token,这两个 token 的生成概率差距越大,说明大模型越肯定。

答案置信度是用于从多条路径中辨别包含正确思维链的路径的手段。正确辨别包含思维链的路径是将本文发现的特点用于增强问答效果的重要步骤。

识别回答中的答案

本文并没有在这里做过多的研究,只是指出了几个可用方法:

- 如果是数学问题,那么回答中的最后一个数字可能是正确答案;

- 集合型问题,可以使用 Tülu评估;

- 提示词指引,要求模型给出回答前说 “So the answer is: “之类的话来进行定位。

和自一致提示的对比

思维链解码看起来和自一致提示一样,但是自一致提示极度依赖特别的提示词,没有提示词辅助将会出问题。

为什么只保留第一个 token 的 top-k

因为自回归架构的特点,后面的 token 受前面生成的 token 影响极大。如果这样干,就会减小大模型修正错误路径的机会。

为什么不从归纳所有路径得到答案

事实证明直接投票恐怕不会有好结果,但是用 $\Delta_{k,a}$ 加权投票倒是可以增强稳定性。

实验

结论

- 这篇文章通过一个小技巧就绕开了提示词使得大模型能直接生成思维链;这表明推理能力是大模型内在固有的;

- 这篇文章发现包含思维链的答案其答案token 的置信度更高;

- 这篇文章用这个思路提出了一个增强大模型回答效果的方案,能显著提高表现并且缩小预训练模型和指令微调模型之间的差距。

启发与评价

- 本文做出了一个很有意义的探索,回答了大模型到底有没有自发生成思维链的能力,并且发掘了思维链和置信度之间的关系;

- 本文的思维链生成方法不需要提示词辅助,可以被嵌入到各种已有的框架中,提高生成表现;

- 本文揭示的思维链和置信度之间的关系对证据链筛选、判定非常有启发性。反过来,这个置信度也可以用于否定证据(低置信度意味着结论不可靠),以及计算多步推理每一步的准确度从而对推理过程整体进行评估;

- 本文对比了 CoT-Decoding 和各种思路的对比,不过没有比较和有提示情况下生成的思维链孰好孰坏,也没有进一步分析置信度的分布和答案正确与否之间是否有强关联。

发表回复