来源:arXiv

作者:Adian Liusie, Potsawee Manakul, Mark J. F. Gales

单位:剑桥大学

发表时间:2023 年 7 月

一、研究背景

NLG评估:

人工评估成本高、耗时长。

传统自动评估方法(如ROUGE、BERTScore)依赖参考文本,且任务特定性强,泛化性差。

现有零样本方法(如ChatGPT评分)需要大规模模型(175B+参数),适用性受限。

LLM潜力:

零样本能力:无需训练即可完成任务。

核心思想:人类更擅长比较而非绝对评分 → 利用LLM进行成对比较(Pairwise Comparison)可能更高效。

研究动机:

探索中等规模LLM(如FlanT5、Llama2)在NLG评估中的表现。

解决位置偏差(Positional Bias)问题,提升评估可靠性。

这篇论文提出了一种基于成对比较的LLM评估框架,研究了LLM在零样本评估下的成对比较能力。

二、方法实现

- 成对比较方法:

给定一个上下文(context)和多个候选文本(比如多个摘要或对话回复),通过成对比较的方式评估它们的质量,而不是对每个文本独立打分。

对于任意两个候选文本x_i和x_j,LLM 被提示生成一个二分类判断:哪个文本更好。

2. 概率计算:

Prompt-Based Classifier(概率输出)—- 可以访问到模型的输出概率

Text Generation(生成式输出)—- 模型只能生成文本

- 去偏策略:

LLM在成对比较中存在位置偏置,即模型更倾向于选择第一个或第二个候选项。

- 子集比较策略:

由于所有成对比较的数量为R=N(N−1),当N较大时计算成本高。因此提出三种策略:

Random:随机选择部分比较进行计算。

No-repeat:同一对文本不重复比较。

Symmetric:每次比较都进行正反两种顺序的计算。

三、实验

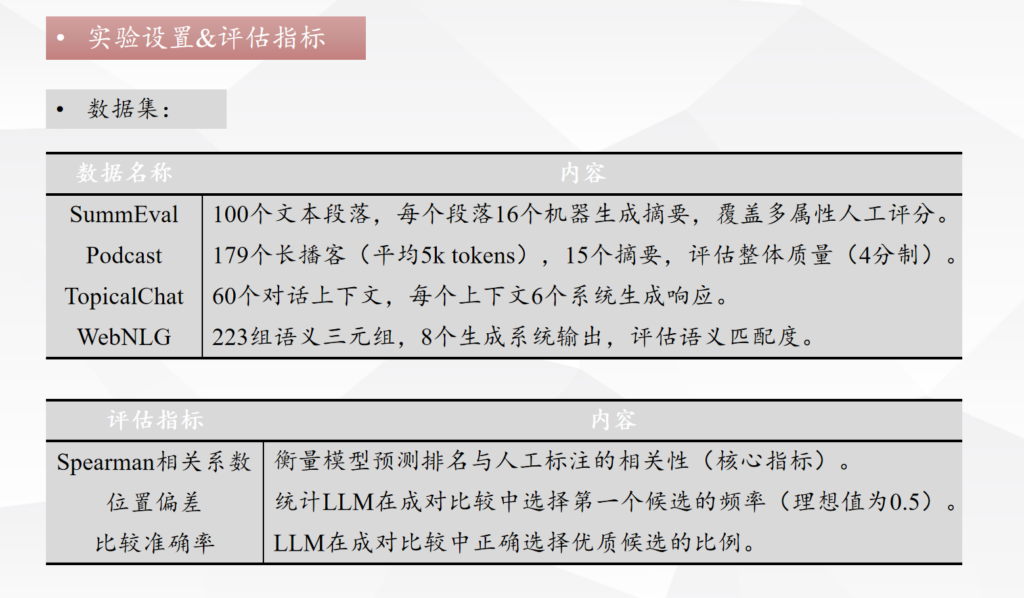

- 实验设置&评估指标

2. 比较评估 vs 绝对评分

实验证明:

对比基线方法:例如 UniEval 和 GPTScore在某些情况下表现更好,但它们要么是有监督的方法(如 UniEval),要么是需要更大规模的 LLM(如 GPT3 和 ChatGPT)。

比较评估:更稳定的表现:中等规模的模型(如 FlanT5-3B)在大多数情况下表现得更好,并且与基于更大模型的系统相比,性能差距较小。

零样本学习:不依赖于标注数据训练,而是通过对比实现评估。

3. 去偏效果验证

问题:LLM在比较中偏向首个候选(如Llama2-7B使用Prompt 2时,候选A被选概率达68%)。

解决方案:

重加权概率(公式9-10):通过调整阈值τ平衡正反向比较。

对称比较策略:强制比较每对的正反顺序。

4.比较子集

实验内容:

比较选择策略:

Random(随机选择): 从所有可能的比较对中随机选择若干个。

No-repeat(不重复选择): 确保每一对(x_i, x_j)只比较一次,而不会同时选择(x_i, x_j)进行反向比较。

Symmetric(对称选择): 每一对(x_i, x_j)都会进行两次比较,意图通过双向对比消除位置偏差。

使用了 SummEval 数据集中的 COH(Coherency)指标,FlanT5-3B模型进行实验。

在所有策略下都同时进行了 原始评估(不去偏) 和 去偏评估(应用去偏策略) 的对比实验。

四、总结与综合对其思考

(一)论文核心内容

论文提出了一种新的评估方法:成对比较评估,并提出了一种去偏方法来减少位置偏差的影响。

其核心思想是:

1.成对比较代替独立评分:

与其对每个文本独立打分,不如对两个文本进行对比判断,选择“哪个更好”。

基于人的评估习惯:人类更擅长相对判断(比较 A 与 B)而不是绝对评分。

2.零样本学习:

这种方法不需要模型进行专门的训练或微调。

利用模型已有的语言理解能力和推理能力,通过对比直接进行评估。

(二)综合对其思考

创新:

通用性强:可以应用于多个评估任务,而不依赖于特定任务的标注数据。

零样本学习:不需要微调或额外训练,只需要利用已有的大语言模型。

偏差检测与校正:提出了一种简单但有效的去偏方法,提升了模型评估的准确性。

改进:

静态选择策略缺陷:当前策略并没有利用已完成比较的信息来指导后续的比较选择,可以考虑引入动态比较子集选择策略。通过在每次比较后,计算每个文本的“置信度”或“不确定性”,优先选择那些对当前排序贡献最大的样本对进行比较。

收获:

当进行产品推荐时,不同产品的呈现顺序可能影响模型的判断。可以学习论文中的去偏方法来提高推荐的公平性和准确性。

模仿论文中的成对比较方法,可以让模型在多个产品中进行两两比较,而不是给每个产品打分。