来源:arXiv

作者:Minghua Zheng, Peng Gao, Renrui Zhang

单位:北京大学、上海AI实验室

一、论文主要工作及贡献

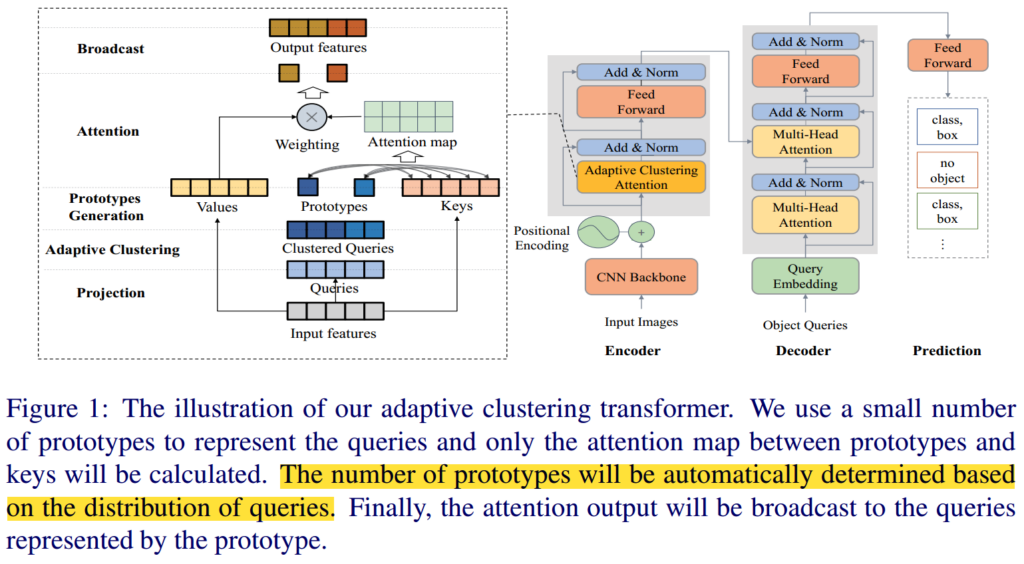

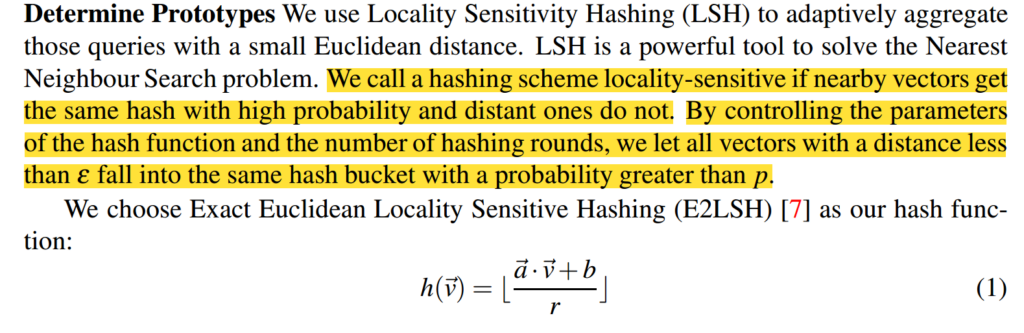

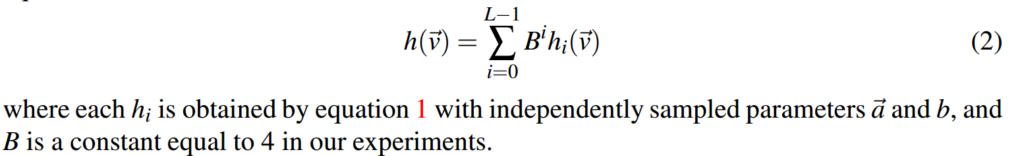

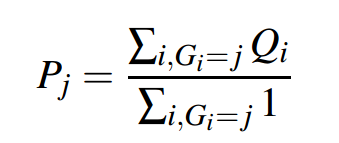

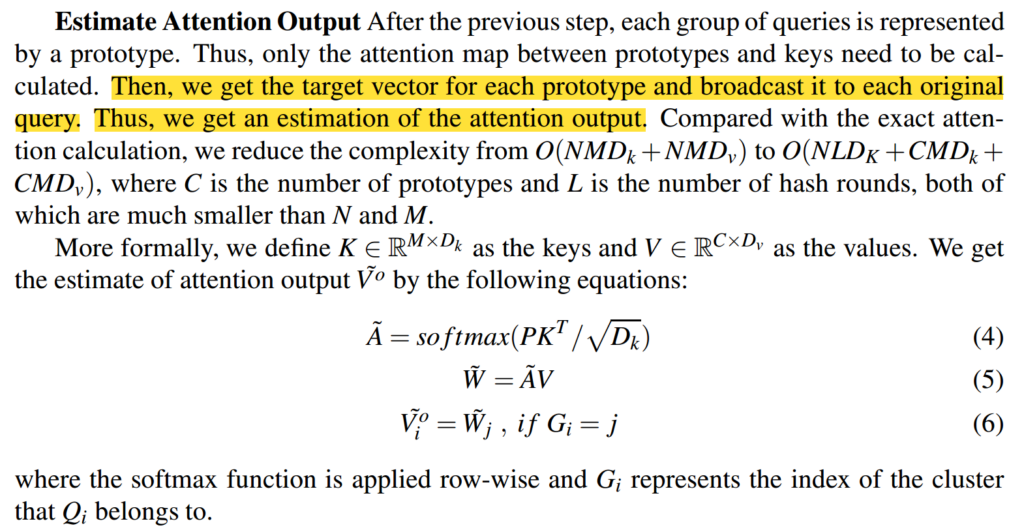

(1)这篇文章提出了一种新的方法,称为自适应聚类transformer(ACT),它可以降低DETR(目标检测transformer)的推理成本。ACT可以降低原transformer的二次复杂度,同时与原transformer完全兼容。

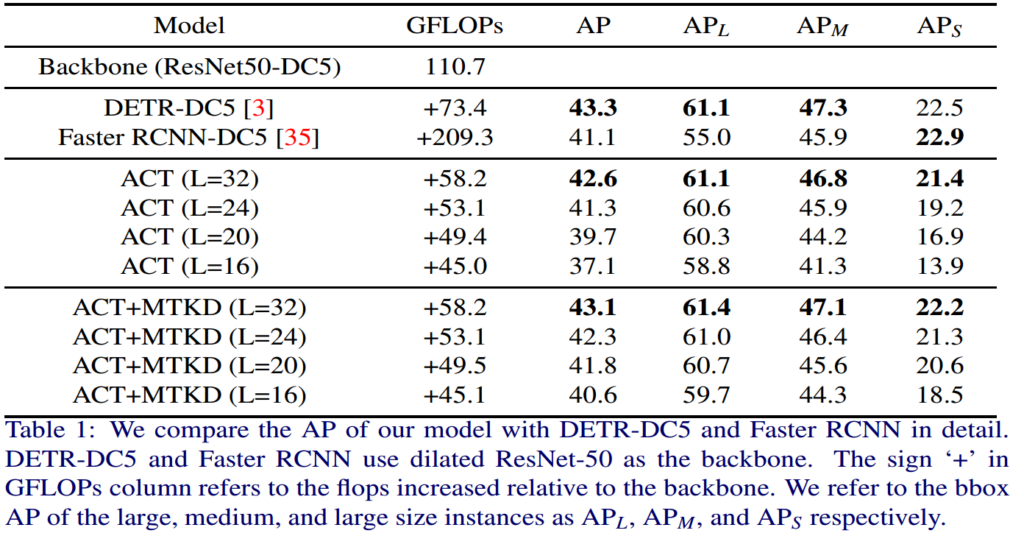

(2)在没有任何训练过程的情况下,ACT将DETR的FLOPS从73.4 Gflops降低到58.2 Gflops(不包括骨干Resnet FLOPS),而AP的损失仅为0.7%。

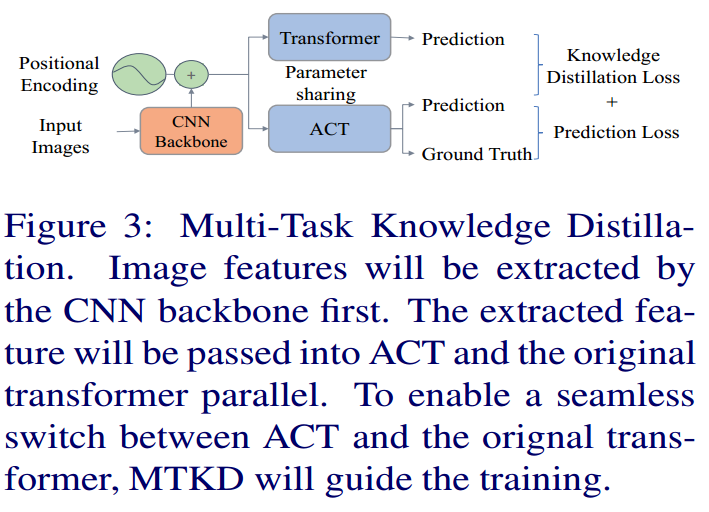

(3)通过多任务知识蒸馏(MTKD),可以进一步将AP损耗降低到0.2%,从而实现ACT和原始transformer之间的无缝切换。

二、模型框架

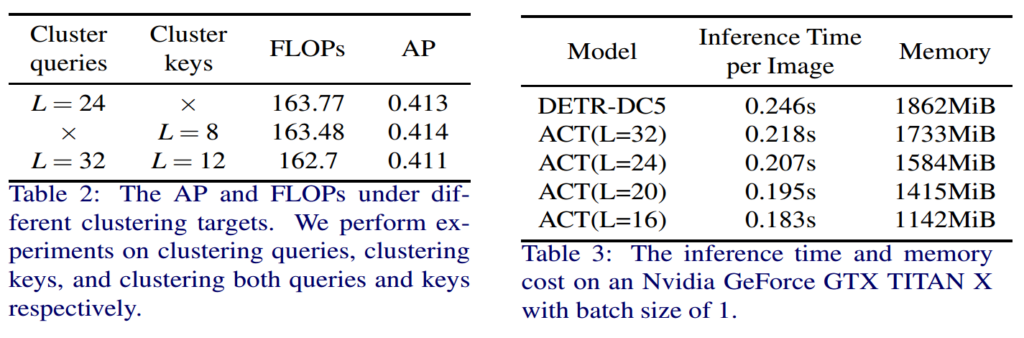

三、实验结果

四、总结与思考

(一)、论文的核心内容:

1.提出了自适应聚类transformer(ACT)来减少目标检测的计算和内存开销。大多数以前的高效transformer在应用于DETR时需要重新培训。由于ACT和Transformer之间的兼容性,这篇文章提出的ACT不需要任何再培训过程。

(二)、综合对齐思考:

1.文章中的自适应聚类transformer主要是针对每个query进行聚类,然后使用一些代表表征来替代这些query进行transformer变换。是否可以拓展应用ACT,将其应用在结构化数据的聚类上。对每一条数据进行自适应的聚类。