来源:NeurIPS 2019

作者: Seongjun Yun, Minbyul Jeong, Raehyun Kim, Jaewoo Kang, Hyunwoo J. Kim

单位:Department of Computer Science and Engineering Korea University

一、论文主要工作及贡献

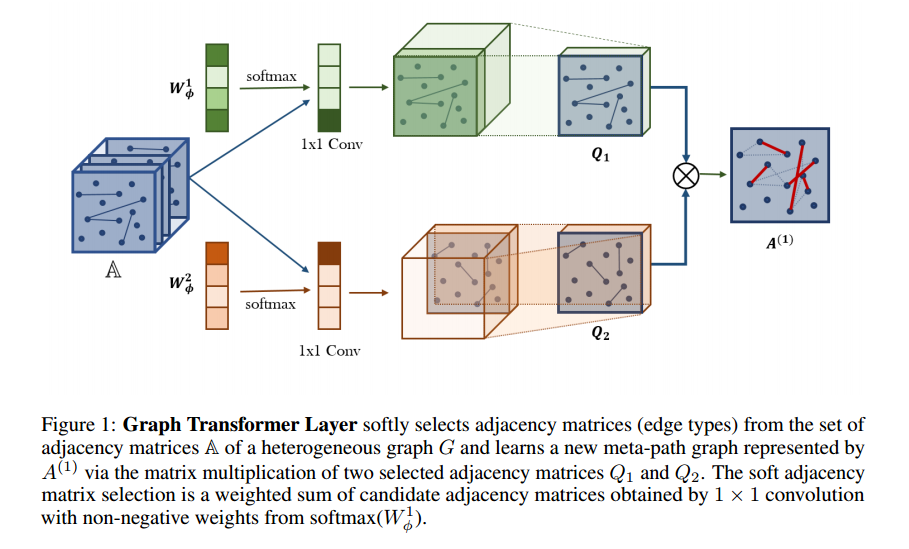

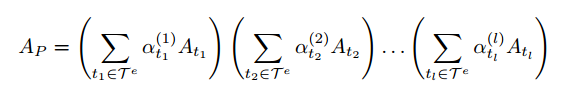

1.本文提出了能够生成新图结构的Graph Transformer Networks,它涉及识别原始图上未连接节点之间的有用连接,同时以端到端方式学习新图上有效的节点表示。Graph Transformer layer是核心层,它学习边缘类型和复合关系的软选择,以生成有用的多跳连接,即所谓的元路径。

2.图形生成是可解释的,模型能够提供有效的元路径进行预测。

二、模型框架

2.1 模型框架图

2.2 Meta-Path Generation

当α不是独热向量时,AP可以看作是所有长度为l的元路径邻接矩阵的加权和。

为了学习包含原始边的短元路径和长元路径,在A中包含单位矩阵I,即A0 = I。这个技巧允许GTN在堆叠L个GT层时学习任何长度的元路径,直到l +1。

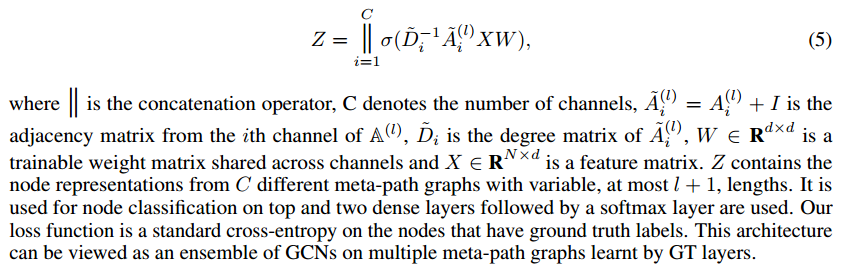

2.3 Graph Transformer Networks

三、实验结果

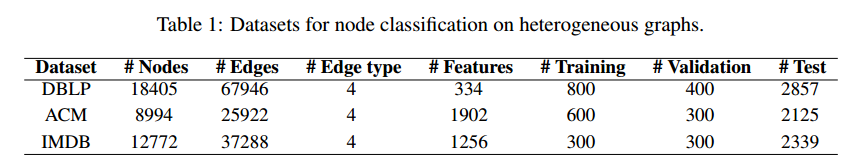

3.1 数据集

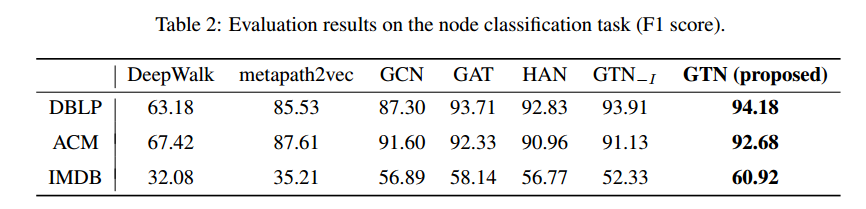

3.2 评估结果

四、总结与思考

1.将一个异构图转换为多个由元路径定义的新图,这些元路径具有任意边类型和任意长度,最多少于graph Transformer层的数量,同时它通过对学习到的元路径图进行卷积来学习节点表示。

2.异构图转换为多元路径的新图可以作为模式归类的一种方法。

3.任意边类型和任意长度也可以作为基图中模式归类的一个点。