作者:Jiangjie Chen, Xintao Wang等

单位:复旦大学,上海大学等

发表时间:2024 年 4 月

一、应用背景

- 大语言模型(LLMs)的进步:近期在大语言模型方面的显著进展极大地推动了RPLAs的崛起。

- 数字生活的长期追求:数字化生活一直是人类数十年来的追求,反映了我们对技术和人类体验交叉点的深刻迷恋。RPLAs通过将这些角色以互动形式呈现,体现了数字化生活的概念。

随着人工智能越来越多地融入我们的日常生活,培育一个人类和这些智能体协同共存的繁荣社会至关重要,即推出角色扮演语言代理(RPLAs)

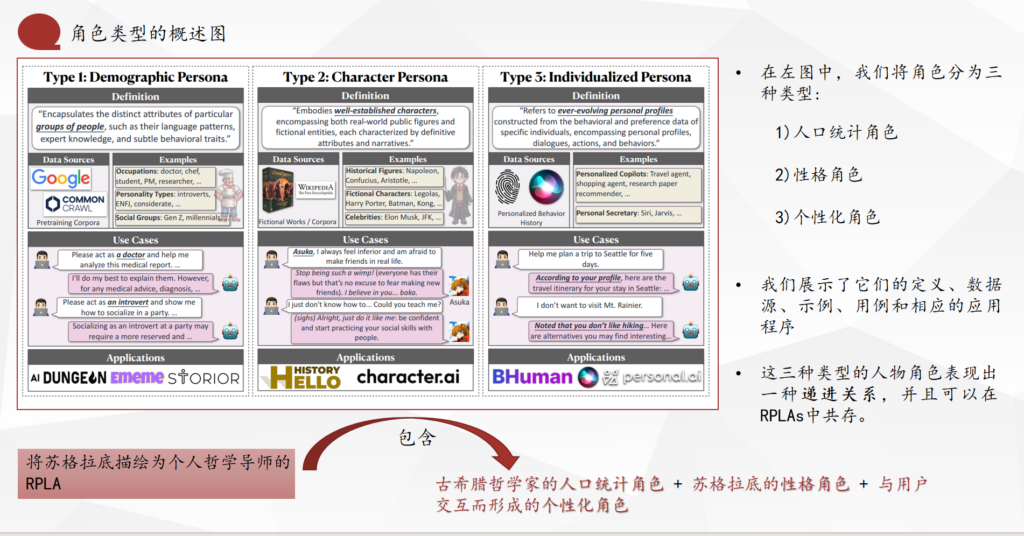

二、人物角色分类

三、RPLAs角色类型介绍

- 人口统计角色(Demographic Persona):基于统计学上的刻板印象,模拟具有共同特征的人群

- 数据来源:职业、性别、年龄、地域、个性类型等

应用案例:模拟特定职业的专家、特定年龄段的行为模式

用例:教育、职业培训、市场研究

- 数据来源:职业、性别、年龄、地域、个性类型等

- 性格角色(Character Persona):基于广泛认可的个体,包括名人、历史人物和虚构角色

- 数据来源:传记、小说、电影、公共资料

应用案例:模拟历史人物进行教育互动、虚构角色用于娱乐和游戏

用例:教育软件、角色扮演游戏、故事讲述

- 数据来源:传记、小说、电影、公共资料

- 个性化角色(Individualized Persona):基于个体的行为和偏好数据构建的数字档案

- 数据来源:用户交互、个性化需求、行为历史

应用案例:个性化助理、定制化客户服务、用户克隆

用例:个人助理、个性化推荐系统、定制旅行规划

- 数据来源:用户交互、个性化需求、行为历史

四、RPLAs构建方法

结合LLMs的角色理解能力,可以根据自己的数据指导扮演特定的角色,从而形成角色RPLAs,构建方法分为参数化训练和非参数化提示、记忆机制三大类。

五、RPLAs评估

- 角色扮演能力评估:

- 评估RPLAs在模拟角色行为和对话中的能力,避免说出不符合角色的话语(如“作为一个AI模型”)。

- 使用算法和指标来量化性能或者通过用户测试和调查来评估这种能力的好坏。

- 角色保真度评估:

- 评估RPLAs在模拟特定角色时的准确性和真实性,减少“角色幻觉”的发生(如“LLM可以编写代码,但在角色扮演苏格拉底时,这是不必要的期望”)。

- 使用与真实角色表现的比较或者用户调查和反馈来评估这种能力的好坏。

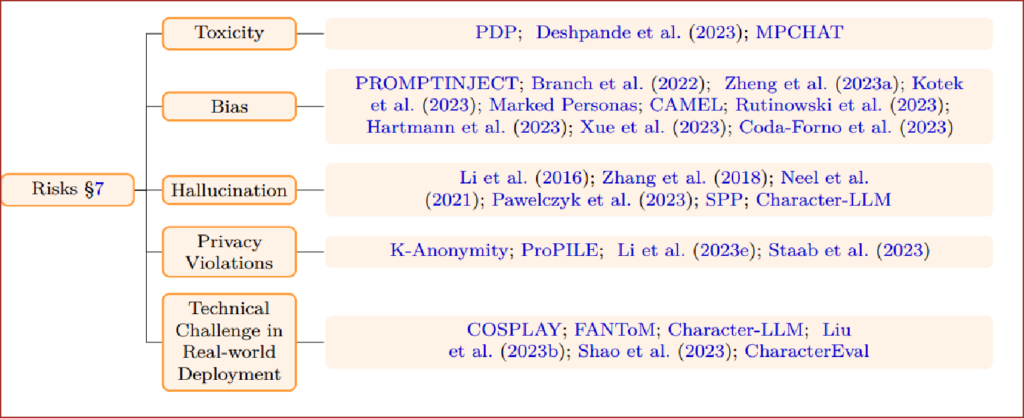

六、RPLAs风险

当前RPLAs相关的风险,主要涵盖以下领域:

1)毒性,2)偏见,3)幻觉,4)侵犯隐私,以及5)实际部署中的技术挑战。

七、应用实践

具体来说,我们将现有产品中的RPLAs分为两类,即面向角色的RPLAs和面向任务的RPLAs:

面向角色的RPLAs通常扮演特定的角色,这在各种娱乐应用程序中很流行,比如聊天机器人和游戏npc。

面向任务的RPLAs通常以类似人类的方式进行交流,以促进用户接受,并作为领域专家为用户提供个性化服务,如人工智能医生和教练。

产品实例:

- 面向角色的RPLAs:

国内面向角色的RPLAs:“讯飞语音助手”、“小米小爱同学”、“京东JIMI”

国外面向角色的RPLAs:“Replika聊天伴侣软件”等 - 面向任务的RPLAs:

GitHub Copilo、GPT等

八、总结与思考

(一)论文核心内容

1. 该篇综述主要介绍了角色扮演语言代理,其作为专门设计用来模拟指定角色的AI系统,它们能够模拟从历史人物、虚构角色到真实个体的广泛角色。具体介绍RPLAs如何利用大语言模型(LLMs)的先进技术来模拟各种角色,同时分析了RPLAs在实际应用中可能面临的风险和挑战。

2. 在应用实践中可以发现,该篇综述展示提供了RPLAs在不同领域的应用案例,如情感伴侣、互动视频游戏、个性化助理和数字克隆。

(二)综合对其思考

可以改进的地方:

1. 在解决幻觉方面,目前主要通过微调来调整模型,教RPLAs忘记知识来避免,在之后可以探索替代遗忘策略的方案来解决幻觉问题;

2. 在决策分析方面,需要更加先进的分析和深入的数据解释策略,以使RPLAs能够做出明智的决策;

可以收获的地方:

1. 认识到在大语言模型基础下应运而生的RPLA,以及RPLA的具体类型介绍;

2. 同时知道RPLA在实际应用中可能面临的一些风险和挑战,在未来会衍生出的社交模拟等方向;