- 作者:Darren Edge,Ha Trinh,Jonathan Larson等

- 来源:2024.04 arxiv

- 单位:微软研究院

- 论文链接:http://arxiv.org//pdf/2404.16130

- 项目开源地址:http://github.com/microsoft/graphrag

一、研究背景

为什么要提出Graph RAG?

RAG,又称检索增强生成,目前已经成为大语言模型应用的核心组件之一,利用检索到的内容来增强大语言模型的外部知识。

因此,RAG在帮助LLM处理私有化数据集(比如企业内部文档、商业文件、用户对话记录等)上取得了不俗的表现。但是,传统RAG仍然存在很多问题,比如:

在处理多信息点(全局问题)时存在困难,比如某个问题的回答需要整合多个文档、多个片段的信息,提供全新的见解时,传统RAG往往在回答的全面性方面存在不足。

二、本文贡献

提出了一种Graph RAG方法,用于在私有文本语料库上进行问答,该方法可以根据用户问题的一般性和要索引的源文本的数量进行扩展。

GraphRAG包括两个处理阶段,分别是:索引阶段和查询阶段。

索引阶段利用LLM来自动化构建知识图谱,提取出对应的节点(如实体)、边(如关系)和协变量(如主张,claim),然后利用社区发现技术(如Leiden算法)对整个知识图谱进行子图划分,然后自底而上对子图利用LLM进行摘要、总结。

针对特定查询,“全局答案(Global Search)”汇总所有与之相关的社区摘要最后汇总生成答案。

三、基于LLM派生的知识图谱的全局总结的Graph RAG方法

1、源文档生成文本片段

与传统RAG一样,GraphRAG也需要将源文档转化为文本片段(TextUnits),这个片段既会被用于图谱抽取,也会作为知识的引用源,以便追溯回最初的原始文本内容。

2、知识图谱构建

对于每一段文本片段,利用LLM从中提取实体、关系、主张(Claim)。

3、元素实例转化为元素摘要

通过LLM对文档中的实体、关系、主张进行提取,本质上是对文档的一种抽象式摘要。不过目前的实体辨识实现是具有破坏性的:将实体提供给LLM,并要求其判断哪些实体应该合并。合并为单一实体后,它们的关系也会相应更新。GraphRAG正在积极探索其他实体辨识技术。

4、元素概要至图谱社群

之前步骤所构建的索引可以视作一个均匀无向加权图。可以应用社群发现算法,将图递归划分为多个社群,社群内的节点间的联系比与图外其他节点更为紧密。

在GraphRAG中,选用了Leiden算法,能够有效地挖掘大规模图谱的层级社群结构。

5、图谱社群至社群概要

用社群(知识图谱子图)数据,让LLM为每个社群总结为一个摘要式报告。这有助于在图谱的不同细节层次上获得宏观的理解。

6、社群概要→社群解答→全局解答

用户的提问全局答复按以下过程生成:

• 准备社群概要。将社群概要随机混洗,并划分为预设的令牌大小的区块。

• 映射社群解答。并行生成每个区块的中间答案。LLM为生成的答案打分,分数范围从0到100,以指示答案对目标问题的帮助程度。得分为0的答案将被排除。

• 汇总为全局答案。根据有用性得分将答案降序排列,并逐步整合进新的上下文窗口,直至达到令牌限制。这一最终上下文将用于生成并返回给用户的全局答案。

四、实验

1、数据集:

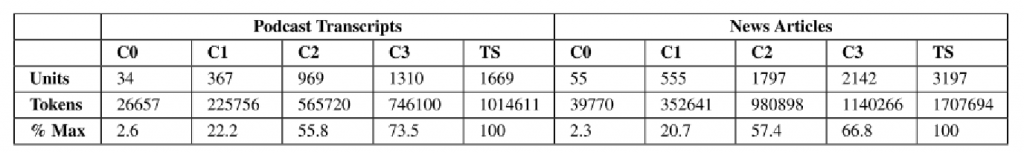

①播客文本,大小:1669×600个令牌文本块,块之间有100个令牌重叠(~100万个令牌);

②从2013年9月到2023年12月在一系列类别中发布的新闻文章,大小:3197 × 600个令牌文本块,块之间有100个令牌重叠(约170万个令牌)。

2、实验对象:

六种配置的RAG,包括利用四层图社群结构的GraphRAG(C0、C1、C2、C3),以及将Map-Reduce应用于原始文本的文本摘要方法(TS)、语义搜索RAG(SS)。

3、评估指标与结果

•全面性&多样性

在全面性和多样性上,GraphRAG的所有条件均超越了朴素RAG。特别是条件C1至C3,在答案的全面性和多样性方面相较于TS(不依赖图索引的全局文本摘要)显示出了小幅提升。

•直接性:朴素RAG在所有对比中提供了最直接的回答。

与源文本摘要相比,Graph RAG的可伸缩性优势:对于低级社区摘要(C3), Graph RAG需要的上下文令牌减少了26-33%,而对于根级社区摘要(C0),它需要的令牌减少了97%以上。与其他全局方法相比,由于性能略有下降,根级Graph RAG提供了一种高效的迭代问题回答方法,该方法具有意义生成活动的特征,同时保留了比朴素RAG更具全面性(72%胜率)和多样性(62%胜率)的优势。

五、总结

- 由于大模型在处理多信息点的全局问题时存在困难,本文提出Graph RAG方法,能够随着问题普遍性和文本量的增加而扩展。

- Graph RAG通过 LLM 构建图索引,先从文档中提取实体图,再预生成相关实体的摘要。在回答问题时,每个摘要生成部分答案,最终汇总为完整回答。